Technologie-Steckbrief

Einleitung

Die Textanalyse ist ein Teilgebiet im Bereich der Verarbeitung von natürlicher Sprache und beschäftigt sich mit der automatischen Analyse von großen Mengen von unstrukturierten Dokumenten (freie Texte oder Dokumente ohne vordefinierte Formate), um relevante Erkenntnisse oder Muster abzuleiten. Dabei werden Methoden und Techniken aus dem Bereich des Maschinelle Lernens, sowie der Statistik und der Computerlinguistik miteinander kombiniert. Sie ermöglicht es, die enormen Inhalte in großen Textmengen für wichtige Entscheidungen zu nutzen und hat daher ein sehr hohes Anwendungspotential für Unternehmen, Regierungen, Forscher:innen und Medien. Bei der Textanalyse kommen verschiedene Techniken zum Einsatz, wie Sentiment-Analyse, Topik-Modellierung, Erkennung von benannten Entitäten, Erkennung von Beziehungen und Ereignissen, Extraktion von Wissensgrafen aus Texten. Die Textanalyse spielt auch eine wichtige Rolle in Bereichen wie der Datensicherheit, Datenprivatheit und der Erkennung von Vorurteilen (Bias) und Falschinformationen in Texten.

Beschreibung der KI-Technologie & KI-Methode/n/-Komponenten

Textanalyse ist nicht eine einzige, monolithische Komponente, sondern vielmehr bestehend aus einer Reihe von Kernkomponenten, die einzeln genutzt oder kombiniert werden, um die spezifischen textanalytischen Aufgaben zu meistern. In den letzten Jahren haben dabei datengesteuerte Verfahren bei der Entwicklung von Lösungen eine besondere Rolle eingenommen. Diese Verfahren basieren im Wesentlichen auf Modellen des Maschinellen Lernens (z. B. Tiefe Neuronale Netzwerke). Die verschiedenen Methoden können dabei danach unterschieden werden, welche textuellen Aspekte von ihnen im Detail modelliert werden.

Erkennung von Eigennamen:

Hier werden Methoden entwickelt, die automatisch Textsegmente (einzelne Wörter oder Wortfolgen) identifizieren können, die Namen von Entitäten entsprechen, wie z.B. Personen, Unternehmen, Institutionen, geografischen Objekten. Die Erkennung von Eigennamen (englisch: Named Entity Recognition, NER) ist nicht einfach durch einen direkten Zugriff auf eine eventuell vorhandene Liste (z. B. eine Liste aller Unternehmensnamen) zu realisieren. Zum einen kann es sein, dass im Text verschiedene Schreibvarianten eines Firmennamens verwendet werden (z. B. „Apple“, „Apple Inc.”, „Apple Deutschland” etc.). Zum anderen könnten Firmennamen auch implizit genannt werden, z. B. „Apple” implizit durch den Ausdruck „der US–Konzern”. Das bedeutet, dass zur Erkennung von Eigennamen nicht nur alle möglichen Namensvarianten zu identifizieren sind, sondern diese auch den korrekten Entitäten zuzuordnen sind.

NER werden in der Regel durch maschinelle Modelle definiert (z. B. Tiefe Neuronale Netzwerke), welche mit Hilfe von großen korrekten beigelegten Textdaten trainiert werden. Da die Erstellung solcher Textannotationen in der Regel aufwendig ist, werden aktuell auch Verfahren entwickelt, die mit wenigen Textannotationen bereits sehr gute Erkennungsraten erreichen. Diese Verfahren basieren auf einem Transferlernen und Fine-Tuning von vortrainierten Sprachmodellen, wie z.B. BERT, GPT-2 usw.

Relationsextraktion:

Die Relationsextraktion hat das Ziel zu bestimmen, ob und welche inhaltlichen Beziehungen im Text für Paare von erkannten Eigennamen ausgedrückt sind, diese zu extrahieren und gegebenenfalls in eine normierte Form zu überführen. Betrachten wir zum Beispiel den Satz „Elon Musk hat Twitter übernommen“. Nehmen wir an, dass die Eigennamenerkennung den Textteil „Elon Musk“ als PERSON erkannt hat und „Twitter“ als UNTERNEHMEN, dann sei das Ergebnis der Relationsextraktion die Relation ÜBERNAHME_FIRMA(„Elon MASK“:PERSON, „Twitter“:UNTERNEHMEN).

Relationserkenner werden in der Regel ebenfalls durch ein Maschinelles Modell definiert (auch neuerdings Tiefe Neuronale Netzwerke). Die allermeisten aktuellen Verfahren sind dabei satzbasiert, wobei die Sätze bereits mittels einer Eigennamenerkennung vorverarbeitet sind. Die Trainingsdaten bestehen dann meist aus einer sehr großen Menge von Sätzen mit annotierten Eigennamen und korrekten semantischen Relationen. Als Grundlage für die auszuwählenden Typen von relevanten Relationen dienen oft vorhanden spezifische Wissensbasen (z.B. Ontologien) oder allgemeine Wissensgraphen, wie z.B. Wikidata. Im letzteres Fall werden dabei zunehmend Trainingsdaten automatisch erstellt, in den Relationen aus Wikidata mit entsprechenden Sätzen aus Wikipedia automatisch annotiert werden.

Sentiment-Analyse:

Die Sentiment-Analyse beschäftigt sich mit der automatischen Auswertung von in Texten ausgedrückten Stimmungen, z.B. positive und negative Meinungen (Polarität) oder Bewertungen. Das Ziel ist es, die durch den unstrukturierten Text vermittelten Emotionen zu ermitteln. Relevante Textquellen umfassen hier Produktbewertungen, Kundeninteraktionen, Beiträge in sozialen Medien, Forumsdiskussionen oder Blogs. Neben der Analyse der Polarität, wird auch eine feinkörnigere Kategorisierung für eine Analyse von Emotionen untersucht, wie z. B. verwirrt, enttäuscht oder wütend. Die Ergebnisse einer Sentiment-Analyse sind hilfreich zur Bewertung von Kundenreaktionen auf ein Produkt oder eine Dienstleistung, zum Verstehen von Trends gegenüber einer Marke, dem Aufdecken von neuen Trends im Verbraucherbereich, der Priorisierung von Kundenbeschwerden oder zur Analyse von Trends in der Kundenzufriedenheit über die Zeit.

Oft kann die Sentiment-Analyse als ein spezielles Textklassifikationsproblem betrachtet werden. Bei einer tiefergehenden Analyse des Textes spielt dabei die Erkennung von Namen und Relationen zwischen ihnen eine naheliegend wichtige Rolle.

Mögliche Anwendungsbereiche

- Mögliche betriebliche Einsatzbereiche:

- Service, Kundenmanagement

- Forschung und Entwicklung

- Marketing und Vertrieb

- Mögliche Branchen: Informations- und Kommunikationstechnologie, Medien, Einzelhandel, Gastgewerbe und Tourismus

Nutzen und Voraussetzungen für KMU

Der größte Nutzen von Text Analytics (TA) für KMU besteht darin, Entscheidungsprozesse wie z. B. in Service- und Kundenmanagement-Aufgaben automatisch zu unterstützen. Durch den Einsatz von modernen KI-basierten TA-Methoden wird eine erhöhte Sichtbarkeit erzeugt und potenziellen Kunden signalisiert, dass das Unternehmen modern ist und es nicht scheut, neue KI-Technologien einzusetzen.

Voraussetzungen sind das Vorhandensein einer geeigneten Serverstruktur, auf der die TA gehostet werden muss. Außerdem müssen idealerweise Kompetenzen im Bereich der Programmierung von TA im speziellen und NLP im Allgemeinen vorhanden sein. Die meisten der aktuell am besten performanten Methoden basieren auf überwachten Trainingsverfahren. Daher ist die Erstellung bzw. Verfügbarkeit von für die jeweilige Aufgabe relevant große Menge von annotierten Daten unabdingbar.

Anwendungsbeispiel

Wir wollen die Aufgabe der Anonymisierung von elektronischen Patientendaten (EPD) als ein Anwendungsbeispiel genauer betrachten, welches im Rahmen des EU-geförderten Projektes Precise4Q (Personalised Medicine by Predictive Modelling in Stroke for better Quality of Life)1 entwickelt wurde. Anonymisierung (bzw. auch die De-Identifizierung) ist die Aufgabe, geschützte Gesundheitsinformationen aus den klinischen textuellen Aufzeichnungen eines Patienten datenschutzkonform zu entfernen.

Gründe für den KI-Einsatz

Mit dem wachsenden Interesse und den Innovationen im Bereich der datengesteuerten digitalen Technologien ist der Datenschutz zu einem wichtigen rechtlichen Thema geworden. In Europa verlangt die Allgemeine Datenschutzverordnung (GDPR) (Verordnung, 2016) von den Dateneigentümern eine Rechtsgrundlage für die Verarbeitung personenbezogener Daten, zu der auch die ausdrückliche Zustimmung der Betroffenen gehört.

In Fällen, in denen eine ausdrückliche Zustimmung nicht möglich ist, wird die Anonymisierung oft als Lösung angesehen. Klinische Texte enthalten umfangreiche Informationen über Patienten (PI), einschließlich Geschlecht, Alter, Beruf, Wohnort, Familie und Vorgeschichte, die für die Aktenführung und Abrechnung nützlich sind. Die Anonymisierung dieser Daten spielt eine Schlüsselrolle in der Medizinischen Informatik zur Erstellung von Modellen, zum Teilen von Daten und zum Schutz der Privatheit der Patienten.

Beschreibung der Anwendung

Im Rahmen des Forschungsprojekts Precise4Q haben wir in Zusammenarbeit mit Partnern des „Brain Health and Neurorehabilitation Institute“ in Barcelona, Spanien eine Methode zur De-Identifikation von elektronischen Patientendaten mit Hilfe von KI-Methoden entwickelt und evaluiert. Anwendungsbereich sind elektronische Notizen von Ärzten zum Rehabilitationsfortschritt, die in (gemischt) spanischen und katalanischen Texten vorliegen.

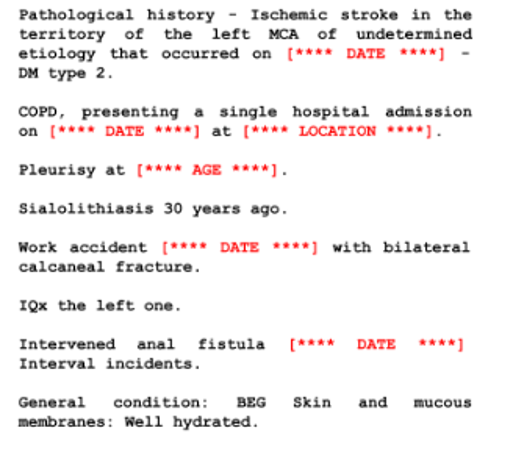

Der Prozess der De-Identifizierung von Texten beinhaltet die Entfernung einer vordefinierten Gruppe direkter Identifikatoren im Text. Bei klinischen Notizen sind dies häufig die PI-Kategorien (oder Typen), die im Health Insurance Portability and Accountability Act (HIPAA) definiert sind, u.a. Name, Beruf, Ort, Alter, Datum, Kontakt, IDs. Das folgende Beispiel zeigt einen de-identifizierten Auszug einer Patientennotiz aus dem spanisch-katalanischen Schlaganfalldatensatz, der in dieser Studie verwendet wurde (zur besseren Lesbarkeit ins Englische übersetzt).

Die Kernidee unseres Verfahrens ist es, De-Identifikation als ein spezielles Problem der Eigennamenerkennung (NER) zu betrachten und ein Lernverfahren zu definieren, das mit speziell für unsere Domain annotierten Daten trainiert wird. Da die manuelle Annotation solch spezifischer Daten jedoch sehr aufwendig ist und in unserem Fall sogar zwei Sprachen umfasst, ist es unser Ziel zu überprüfen, wie und mit welcher Methode wir den notwendigen Annotationsaufwand verringern können. Glücklicherweise existiert für Spanisch ein synthetisch erstellter annotierter Korpus mit Namen MEDDOCAN2 von klinischen Fallbeschreibungen unterschiedlicher Bereiche (allerdings nicht zum Thema Schlaganfall), der ebenfalls die PI-Typen verwendet. Der Korpus umfasst 16.299 annotierte Sätze. Das Ziel ist es nun, auf Basis dieses Korpus ein NER-Modell zu trainieren, das anschließend mit einem sehr viel kleineren annotierten Korpus aus unserer speziellen Domäne verfeinert wird. Man nennt diese Art des maschinellen Lernens auch Transfer-Lernen, genauer Fine-Tuning. Wichtig zu beachten ist, dass unser annotierter Korpus zu ungefähr gleichen Teilen spanische (47%) und katalanischer Sätze (53%) umfasst. Um zu untersuchen, wie gut eine Verfeinerung eines bestehenden Modells aus einer anderen Sprache (hier katalanisch) und Domäne (hier Schlaganfall) mit nur wenigen Beispielen aus einer neuen Domäne ist (man spricht auch von Domänen-Adaptivität), haben wir zuerst das originale MEDDOCAN-basierte NER-Modell direkt auf unsere 3.924 Testbeispiele ausgewertet und einen Wert von 73,7% F1-Mass erreicht (F1 ist ein Verhältnis von Erkennungsrate und Genauigkeit). Das mit unserem um eine kleine Menge von 384 domänenspezifischen Sätzen angereicherte Modell erreicht dagegen ein F1-Mass von 91.2%.3

Vorteile im Unternehmen durch den KI-Einsatz

Der Vorteil der Methode des Transfer-Lernens im Allgemeinen und für die De-Identifikation von kritischen Daten liegt darin, dass hiermit der notwendige Aufwand der Annotation von Trainingsdaten vermindert werden kann und damit einen positiven Kostenfaktor darstellt.

Quellenverzeichnis

2. https://ceur-ws.org/Vol-2421/MEDDOCAN_overview.pdf

3. Genauere Details findet man in: Saadullah Amin, Noon Pokaratsiri, Morgan Wixted, Alejandro García-Rudolph, Catalina Martínez-Costa, and Günter Neumann (2022) Few-Shot Cross-lingual Transfer for Coarse-grained De-identification of Code-Mixed Clinical Texts, Proceedings of the 21st Workshop on Biomedical Language Processing. ACL-2022 BioNLP, May 22-27, Pages 200-211 ACL 5/2022. (BioNLP-2022), May, 2022.